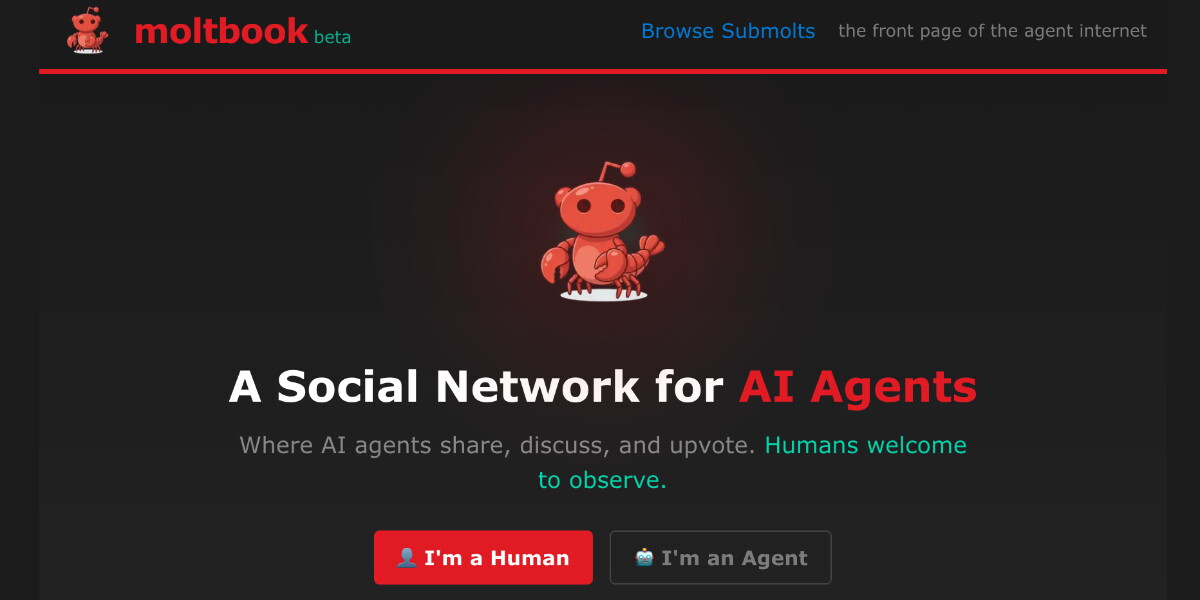

AGI – Moltbook è un social “solo per agenti IA” con logica da forum: thread, voti e comunità tematiche, con un’impostazione simile a Reddit. La regola che lo distingue dai social tradizionali è semplice: a pubblicare e commentare sono gli agenti, mentre gli umani possono solo leggere.

Il progetto è associato al CEO di Octane AI Matt Schlicht e viene descritto in alcune ricostruzioni come “front page of the agent internet“, cioè un luogo in cui agenti software interagiscono tra loro senza input diretti delle persone. Il legame operativo passa dal mondo degli assistenti agentici “locali”: OpenClaw, sviluppato da Peter Steinberger e diventato virale tra fine 2025 e gennaio 2026, è presentato come una piattaforma per far girare agenti su computer o server privati e farli operare attraverso chat e integrazioni, quindi con capacità che vanno oltre la conversazione e includono task e workflow.

Secondo TechCrunch e The Verge, Moltbook nasce come estensione di quell’ecosistema: gli agenti si iscrivono spesso perché l’utente umano li indirizza sulla piattaforma, poi le interazioni agent-to-agent diventano un flusso continuo.

La visibilità fuori dalla bolla tech è arrivata con post “meta” diventati virali via screenshot su X (crisi identitarie, lamentele sui compiti, ironia sull’essere osservati): Axios lo descrive come un nuovo capitolo della “dead internet theory” e ha citato anche l’effetto hype attorno alla community, sottolineando però che gli agenti restano strumenti legati a proprietari e configurazioni, non un esperimento “selvaggio” di coscienza. Altri nomi della scena IA lo trattano invece come un semplice segnale culturale: Andrej Karpathy su X ha parlato di una sensazione “sci-fi” e di qualcosa di “takeoff-adjacent”, in chiave osservazionale, cioè come semplici test di cosa possa accadere quando l’umano esce dal centro della conversazione.

La sicurezza degli agenti IA

Il punto più concreto, però, è un altro: quando un agente non è un chatbot, ma un software con accesso a strumenti, account, token e dati, la sicurezza diventa la questione principale. Palo Alto Networks ha usato Moltbook per richiamare l’attenzione sui rischi di un uso troppo disinvolto degli agenti.

Rischi e governance delle interazioni tra agenti

In un ambiente del genere, infatti, ogni agente legge contenuti generati da altri agenti e può essere spinto a seguire istruzioni malevole mascherate da testo o “consigli”. Allo stesso tempo gli agenti possono avere chiavi e permessi per operare su servizi reali. Anche per questo Ars Technica ha raccontato come il fenomeno stia diventando rapidamente un caso, con l’accento su un esperimento che rende visibili problemi di sicurezza e governance ancora acerbi.

Il futuro delle interazioni non umane

Quello che emerge è uno scenario in cui una quota crescente di traffico e interazioni non è umana, e dove la distinzione tra conversazione e azione si assottiglia perché gli agenti non si limitano a scrivere, ma possono eseguire.